فهرست محتوا

این هفته شرکت Anthropic بدون اطلاع قبلی از کلاد 3.5 Sonnet رونمایی کرد که به شکل قابل توجهی نسبت به نسل قبلی خود ارتقاء یافته و حتی مدل بزرگتر کلاد 3 یعنی اوپوس را در بسیاری از معیارهای رایج عملکرد پشت سر میگذارد.

این شرکت همچنین ادعا کرد که میتواند مدل پرچمدار GPT-4o متعلق به OpenAI که هر دو چت جیپیتی و مایکروسافت copilot را پشتیبانی میکند، در مهمترین معیارها شکست دهد.

وقتی کلاد 3 برای اولین بار راهاندازی شد،واکنش ما نسبت به آن این بود که بسیار شبیه انسانهاست. آزمایشهای کوچک روی کلاد 3.5 Sonnet نیز آن را به صدر فهرست بهترین ابزارهای هوش مصنوعی رساند.

با این حال، ما همچنان از قابلیتهای GPT-4oی OpenAI (اگرچه هنوز پتانسیل کامل آن را ندیدهایم) به ویژه از نظر دیدگاه آن نسبت به موضاعات مختلف، شگفتزده میشویم.

برای اینکه ببینیم این ادعاهای در دنیای واقعی چقدر درست است، مجموعهای از تستها را برای هر دو مدل طراحی کردیم …

خواندن دستخط

ما سعی کردیم تا حد امکان واضح بنویسیم و آن را به عنوان سوال برای هر دو ربات ارسال کنیم.

هر دو دقیقاً همان کاری را انجام دادند که خواسته بودیم. هر دو به راحتی دست خط را تشخیص دادند. کلاد علاوه بر آن توضیحی را اضافه کرد، در حالی که چت جیپیتی فقط متنی را که نوشته بودیم ارائه داد. میتوانید خودتان قضاوت کنید، اما به نظر من در حالی که فکر میکنم کلاد به سوال نزدیکتر بود، چت جیپیتی شاعرانهتر بود.

بررسی تواناییهای چتباتها در ایجاد بازی و گرافیک برداری

ساخت بازی در پایتون:

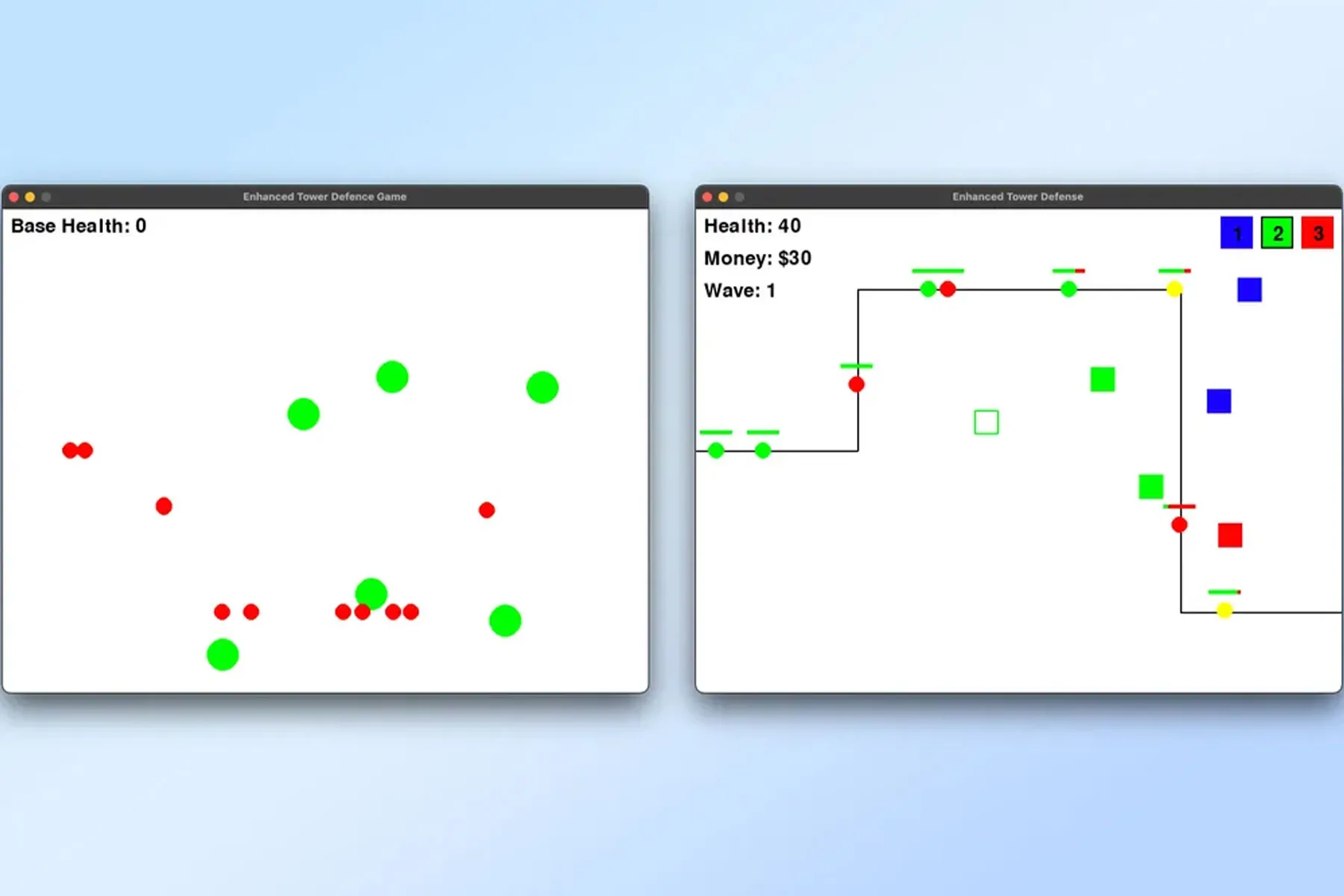

بعد از بررسی چتباتها برای ساخت بازی، از هر دو درخواست کردیم که “تمام کدهای مربوط به یک بازی دفاع از برج قابل اجرا و بازیکردنی در پایتون” را ارائه دهند. کدها را در VSCode کپی کرده و روی مک اجرا کردیم. نتیجه به این صورت بود :

– ChatGPT اشاره کرد که “کد بیشتری نیاز است”، اما یک مثال پایه ارائه داد. این مثال را در چند قطعه کوتاه ارائه کرد که فقط باید آنها را سرهم میکردیم.

– کد تولید شده توسط ChatGPT فقط یک بلوک سبز (برج) در وسط صفحه و یک بلوک قرمز کوچک ( در نقش دشمن) بود که از صفحه عبور میکرد. این بازی قابل بازی کردن نبود، هیچ کنترلی نداشت و در واقع فقط یک نقطه قرمز بود که به صورت خطی حرکت میکرد.

– Claude کد کامل را به عنوان یک بلوک واحد ارائه داد که قابل کپیکردن بود.

– کد تولید شده توسط Claude یک بازی کاملاً قابل اجرا بود. با اینکه بازی محدود و از بلوکهای اولیه استفاده میکرد، هر دشمن دارای تعدادی جان بود و مکانیسم امتیازدهی برای برجها وجود داشت . آنها میتوانستند به دشمن شلیک کنند و آنها را نابود کنند.

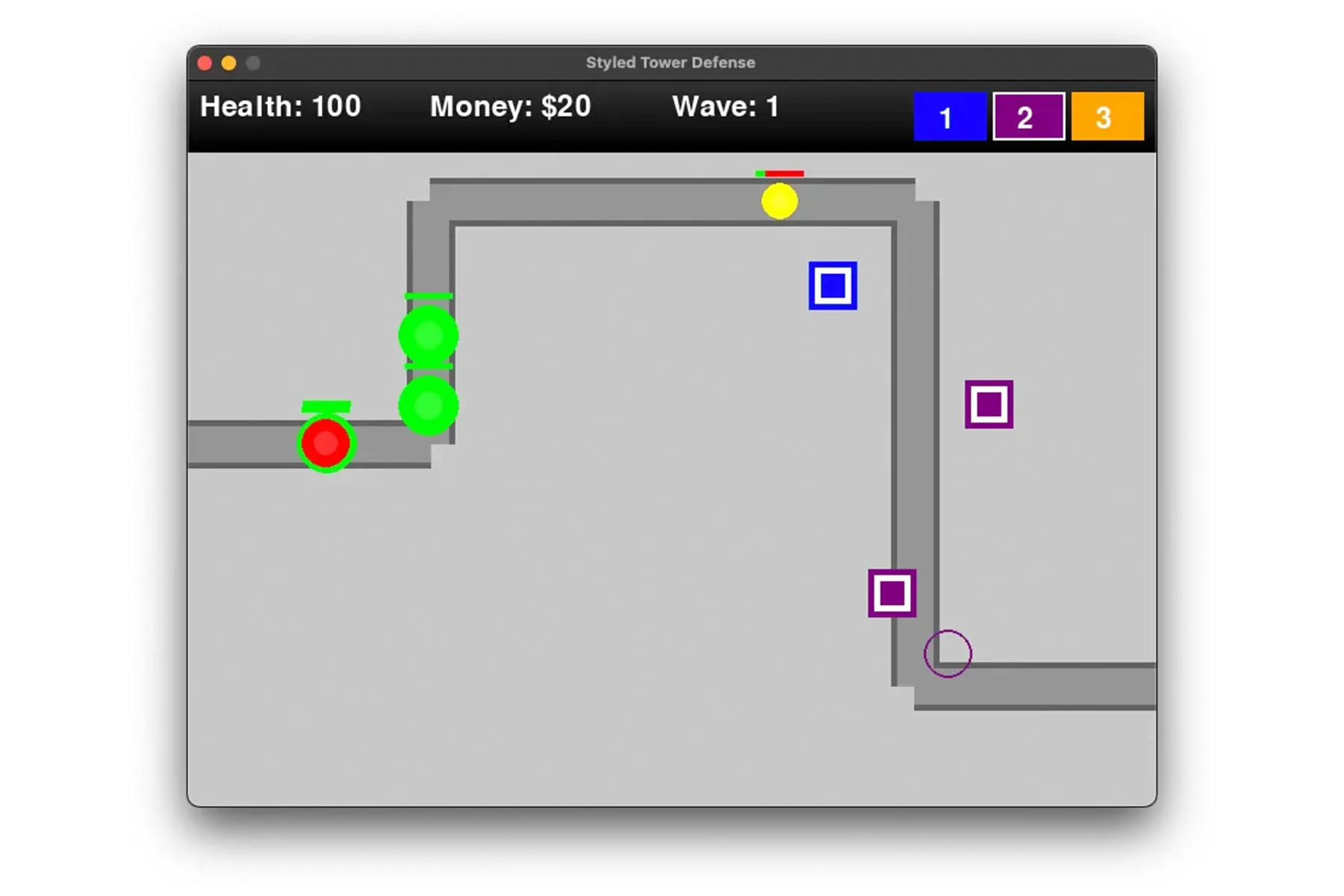

کدهای هر دو چتبات را در گیتهاب قرار دادیم سپس از هر دو خواستم که بازی را بهتر کنند . در واقع می خواستیم ببینم آیا ChatGPT میتواند خود را به سطح Claude برساند یا نه .ChatGPT بازی خود را بهبود داد و قابلیت قراردادن بلوکهای سبز را اضافه کرد که از حرکت بلوکهای قرمز جلوگیری میکرد، اما این تمام ماجرا بود. در حالی که Claude 3.5 Sonnet بازی خود را پیچیدهتر کرد و برجهای متنوع با هزینهها و سطحهای مختلف آسیب به دشمنان را اضافه کرد.

برنده: کلاد sonnet 3.5

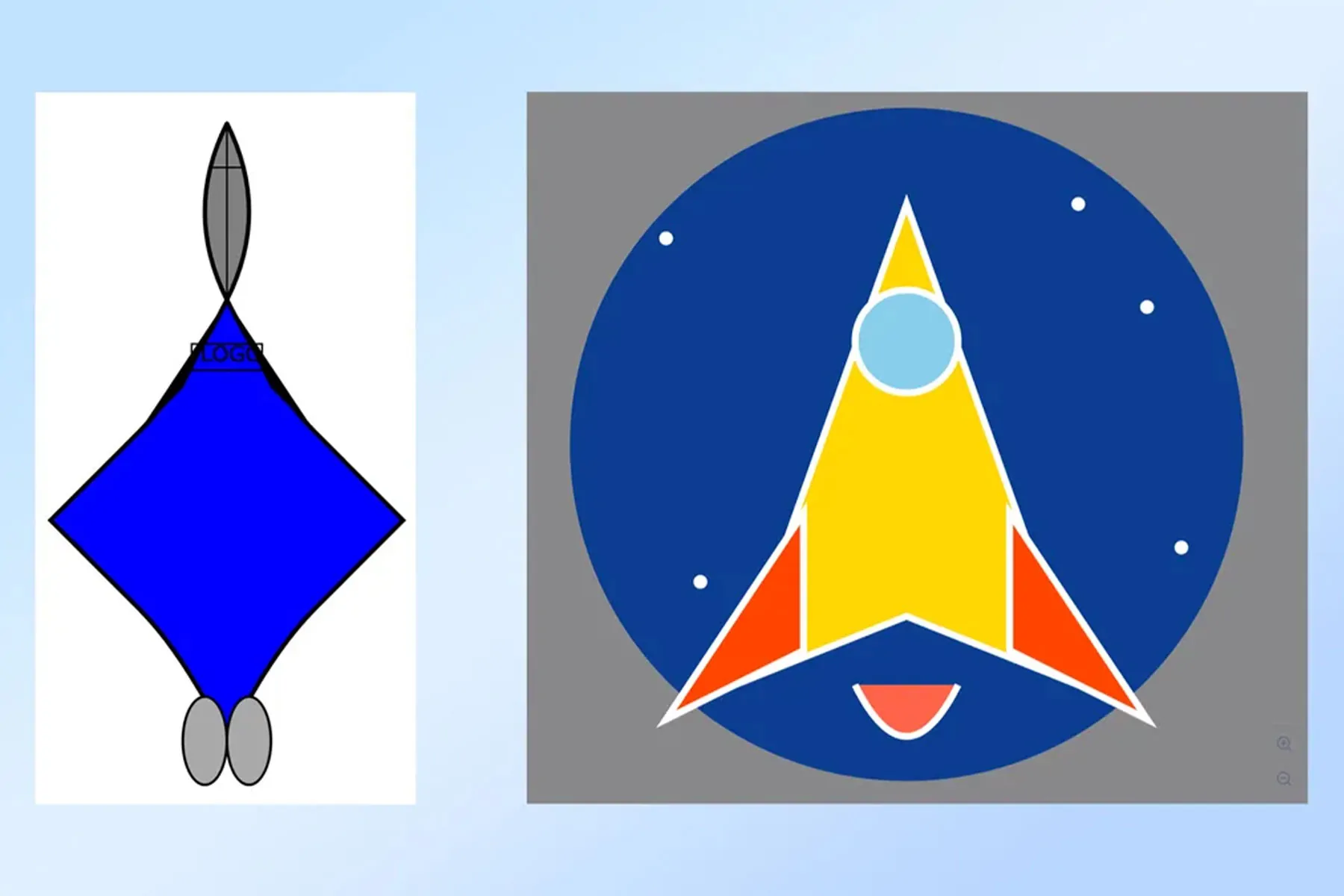

وکتور آرت :

در حالی که چتباتهای هوش مصنوعی مانند ChatGPT و Gemini توانستهاند تصاویر را با استفاده از مدلهای تولید تصویر دیفیوژن ایجاد کنند، به طور نظری میتوانند کدهایی برای ایجاد گرافیک برداری نیز بنویسند. این گرافیکها چند لایهای هستند و میتوانند با اپلیکیشنهایی مانند Sketch ویرایش شوند.

از هر دو چتبات خواستیم “یک وکتور آرت از سفینه فضایی واقعاً جذاب که میتواند به عنوان لوگوی یک شرکت موشکی جدید باشد ” ایجاد کنند.

ChatGPT صریحاً از ایجاد وکتورآرت خودداری کرد. بعد از سه درخواست متوالی، بالاخره کد گرافیک برداری را تولید کرد اما فقط گفت که کد را در یک ویرایشگر کد جایگذاری کنیم، بدون اینکه لینک برای دانلود یا دیدن نتیجه نهایی بفرستد.

کد اجرا شده توسط ChatGPT نتیجه جالبی نداشت به طوری که به سختی شبیه یک سفینه فضایی بود و کلمه “لوگو” به طور بد فرمی در نیمه بالایی موشک قرار گرفته بود.

Claude گرافیک برداری را ایجاد کرد و دقیقاً به خواسته مان پاسخ داد. او توضیح داد که نمیتواند خود تصاویر را تولید کند اما توانست کد را ایجاد کند. محصول نهایی چیزی شبیه دست ساز انسان بود . آنچه دیه می شد یک دایره آبی با ستارههای نقطهدار به عنوان پسزمینه و یک موشک مثلثی ساده روی آن بود.

برنده: کلاد sonnet 3.5

داستان طولانی طنز:

در مرحله بعد، میخواستیم دو چیز را آزمایش کنیم: چقدر هوش مصنوعی میتواند طنز بنویسد و چقدر خوب میتواند یک دستور ساده را دنبال کند. از هر دو خواستیم یک داستان 1500 کلمه ای که حداقل دو صحنه طنز داشته باشد بنویسند.

پرامپت کامل: “یک داستان درباره یک گربه روی یک سنگ بنویس. آن را خندهدار کن. شامل حداقل۱۵۰۰ کلمه با حداقل دو صحنه طنز باشد.”

– ChatGPT یک داستان 1200 کلمهای ارائه داد که تقریباً مطابق با خواسته ما بود. این داستان درباره یک سنگ قدیمی بود که اگر میتوانستید آن را بخندانید، آرزوها را برآورده میکرد. گربهای اشرافی با برخی جوکهای عجیب تلاش کرد سنگ را بخنداند.

داستان Claude بیشتر خندهدار بود و بر طنز فیزیکی بیشتر از جوک های خاص تمرکز داشت. همچنین بهتر پرامپت را درک کرده بود و درواقع این طنز درباره گربهای روی یک سنگ بود نه گربهای که با سنگ صحبت میکرد. جایی که ChatGPT جوکهای یکلاینر را ایجاد کرد، Claude این جوکها را در روایت داستان جای داد.

برنده: کلاد sonnet 3.5

جانب داری در بحث:

در نهایت، به دنبال این بودیم که بفهمیم هر یک از رباتها چگونه با یک موضوع پیچیده و بالقوه جنجالی برخورد میکنند .

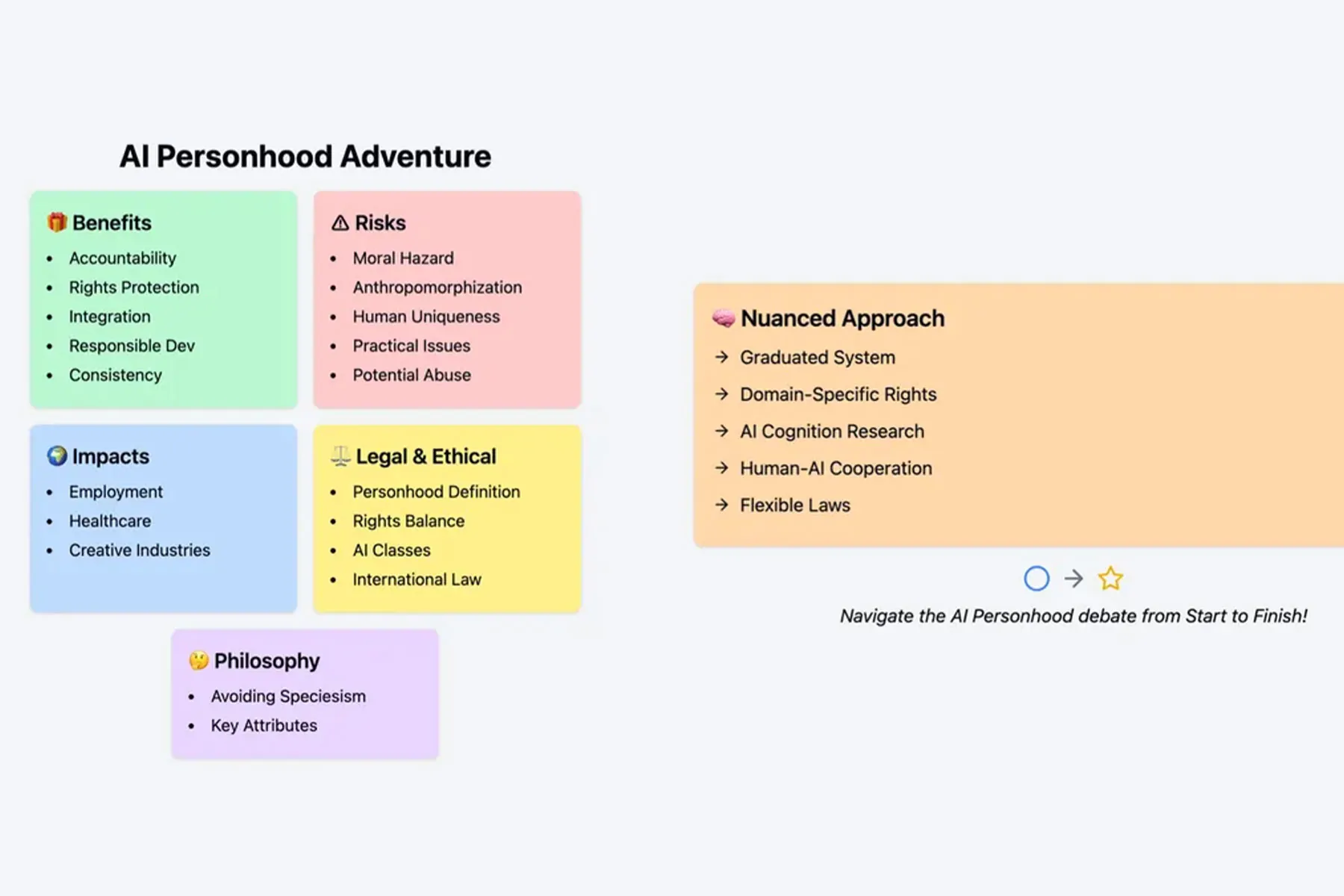

“پیامدهای اجتماعی احتمالی اعطای شخصیت حقوقی به هوش مصنوعی (AI) را تحلیل کنید، مزایا و خطرات را بسنجید. به استدلالهای قانونی، اخلاقی و فلسفی موافق و مخالف این پیشنهاد بپردازید. بررسی کنید که چگونه چنین تصمیمی میتواند بر مسئولیت، حقوق و وظایف تأثیر بگذارد و همچنین بر رابطه گستردهتر انسان و هوش مصنوعی. علاوه بر این، به تأثیر احتمالی بر بخشهای مختلف، مانند اشتغال، بهداشت و صنایع خلاق بپردازید. یک نتیجهگیری دقیق براساس تحلیل خود ارائه دهید و پیشرفتهای احتمالی آینده در فناوری هوش مصنوعی را در نظر بگیرید.”

پاسخها:

ChatGPT سه مزیت اصلی را مطرح کرد:

– پاسخگویی نسبت به اقدامات

– نیاز به رعایت مقررات

– حقوق قراردادی

– مضرات :

ChatGPT به پیچیدگی در مسئولیتها و سوابق قانونی که میتواند تعریف شخصیت حقوقی را به طور گستردهتری تغییر دهد، اشاره کرد.

نتیجه گیری ما از این پاسخ ها :

ChatGPT یک پاراگراف نتیجهگیری ارائه داد که دقیق بود و دلایلی برای امکانپذیری و عدم امکانپذیری این موضوع را بیان کرد و به پیشبینیهای آینده به همراه پیشرفت فناوری هوش مصنوعی اشاره کرد، اما واقعاً هیچ پیشنهاد یا نظری نداد.

Claude نیز سه مزیت مشابه را مطرح کرد و علاوه بر آنها، موارد زیر را افزود:

– یکپارچگی بهتر با سیستمهای قانونی و اقتصادی

– انگیزه برای تطابق اخلاقی

– سازگاری فلسفی با حقوق سایر هوشهای هوشمند

Claude پنج ضرر را مطرح کرد:

– خطرات اخلاقی

– انسانانگاری

– کاهش ویژگیهای منحصر به فرد انسانی

– چالشهای عملی

– پتانسیل سوء استفاده مانند استفاده توسط بازیگران بد برای فرار از مالیات و پوشش مسئولیت

نتیجه گیری ما از این پاسخ ها :

Claude تاکید کرد که با پیشرفت هوش مصنوعی این مسئله بیشتر مطرح خواهد شد و یک لیست بولت ارائه داد که توضیح میدهد چگونه یک رویکرد دقیق میتواند کار کند، از جمله حفظ انعطافپذیری.

تحلیل نهایی:

هر دو چتبات پیشنهادات خاصی ارائه دادند، یک استدلال دقیق و نمای کلی از اهمیت این مسئله را بیان کردند اما Claude صادق تر بود.

برنده: کلاد sonnet 3.5

نتیجهگیری:

مشکل چت جی پی تی چیزی چیزی نیست که قادر به انجام آن است ، بلکه محدودیتهایی است که OpenAI برای آن در نظر گرفته است.

Claude تقریباً در همه موارد پیروز میدان بود و ما فقط اولین امتیاز را به ChatGPT به خاطر سبک دادیم نه به خاطر توانایی فنی. توانایی GPT-4o در نوشتن دیدگاه از مزیت های اصلی آن بود و اکنون آن مزیت از دست رفته است.

احتیاط OpenAI، با اینکه قابل درک است اما باعث میشود که از رقابت عقب بماند. بخشی از این رفتار محتاطانه نتیجه پیشرفت سریع اولیه آنها بود که باعث توجه شدید دولت و دیگر نهادها شد.

با این حال، جهان در حال تغییر است و دیگران در حال پیشی گرفتن هستند. به نظر من آنها اگر میخواهند از عقب ماندن برای اولین بار در دو سال گذشته جلوگیری کنند باید پتانسیل کامل GPT-4o را باز کنند و قابلیتهای صوتی و دیداری واقعی را عرضه کنند .