فهرست محتوا

اگر با خطای blocked by robot.txt یا مسدود شده توسط robots.txt در Google Search Console مواجه شده اید، احتمالاً گیج شده اید که این ارورها چه معنی دارند و چگونه می توان آن ها را رفع کرد. در این مقاله قصد داریم این دو ارور را بررسی کنیم و روش های مؤثری برای رفع آن ها ارائه دهیم.

تفاوت اصلی بین «Blocked by robots.txt» و «indexed though Blocked by robots.txt »

تفاوت اصلی این دو ارور در ایندکس شدن صفحات است:

- خطای blocked by robot.txt : به این معنی است که موتور جستجو صفحه شما را ایندکس نخواهد کرد و آن صفحه در نتایج جستجو نمایش نخواهد یافت.

- ایندکس شده، اما مسدود شده توسط robots.txt: به این معنی است که صفحه شما در نتایج جستجو ایندکس شده است، اما شما قصد داشته اید آن را در فایل robots.txt مسدود کنید.

آیا صفحه ای که در robots.txt مسدود شده واقعاً از موتورهای جستجو مسدود می شود؟

خیر.

هیچ URL کاملاً از ایندکس شدن در موتورهای جستجو مسدود نمی شود حتی اگر در فایل robots.txt مسدود شود. به عبارت دیگر، گوگل ممکن است به طور کامل به درخواست شما برای مسدود کردن صفحه از ایندکس توجه نکند. گوگل در مستندات خود گفته است که ضمانتی برای عدم ایندکس شدن صفحات مسدود شده توسط robots.txt وجود ندارد.

این مشکل در سایت های مختلفی که من و دیگر متخصصین سئو مدیریت کرده ایم، مشاهده شده است. به عنوان مثال، Lily Ray توضیح می دهد که صفحاتی که توسط فایل robots.txt مسدود شده اند، هنوز ممکن است در نمایه های هوش مصنوعی گوگل با اسنیپت نمایش داده شوند.

چطور خطای blocked by robot.txt را در Google Search Console رفع کنیم؟

بررسی دستی تمام صفحاتی که در گزارش « blocked by robot.txt» قرار دارند.

اولین گام این است که صفحات مسدود شده توسط robots.txt را در Google Search Console به طور دستی بررسی کنید. برای دسترسی به این گزارش، به بخش Google Search Console بروید و در بخش Pages، گزارش «مسدود شده توسط robots.txt» را پیدا کنید.

بعد از دسترسی به این گزارش، داده ها را به Google Sheets، Excel یا CSV صادر کرده و آن ها را فیلتر کنید.

تعیین کنید که آیا قصد داشتید URL را از موتورهای جستجو مسدود کنید یا نه

پس از صادر کردن داده ها، با دقت به صفحات نگاه کنید و تعیین کنید که آیا واقعاً قصد داشته اید این صفحات را از ایندکس موتورهای جستجو مسدود کنید یا خیر. گاهی اوقات ممکن است برخی صفحات، مانند صفحات «تشکر» یا صفحات مخصوص تیم های فروش که قرار نیست در نتایج جستجو ظاهر شوند، به طور عمدی مسدود شده باشند.

اگر برای مسدود کردن این صفحات دلیلی منطقی دارید، هیچ نیازی به انجام تغییرات نیست. اما اگر این دستور به اشتباه در فایل robots.txt قرار گرفته باشد، باید آن را اصلاح کنید.

حذف دستور «Disallow» از فایل robots.txt

اگر به اشتباه دستور «Disallow» را برای یک URL اضافه کرده اید، باید آن را از فایل robots.txt حذف کنید. پس از انجام این کار، URL مورد نظر را در بخش Inspect URL در Google Search Console وارد کرده و روی گزینه «Request Indexing» کلیک کنید.

اگر چندین URL در یک پوشه دارید، پیشنهاد می شود که ابتدا URL اصلی آن پوشه را بررسی کنید، زیرا تغییرات در این URL تأثیر بیشتری خواهند داشت.

درخواست برای کرال مجدد فایل robots.txt

راه دیگر برای جلب توجه گوگل به صفحات مسدود شده به طور تصادفی این است که از Google Search Console درخواست کنید فایل robots.txt شما دوباره خزیده شود. برای این کار به مسیر Settings > robots.txt بروید و سپس روی سه نقطه کنار فایل robots.txt خود کلیک کرده و گزینه Request Recrawl را انتخاب کنید.

پیگیری عملکرد قبل و بعد از اصلاحات

پس از پاک سازی دستورات «Disallow» از فایل robots.txt و ارسال URLها برای خزیدن مجدد، پیشنهاد می شود که عملکرد سایت خود را پیگیری کنید. می توانید از ابزار Wayback Machine استفاده کنید تا تاریخ آخرین بروزرسانی فایل robots.txt را مشاهده کنید و بررسی کنید که چه تأثیری بر URLهای خاص داشته است.

سپس، برای حداقل 90 روز پس از ایندکس شدن URL، عملکرد آن را در گزارش ها بررسی کنید تا ببینید اصلاحات چقدر بر سئو و ایندکس سایت شما تأثیر داشته اند.

نکات کلیدی برای رفع خطای blocked by robot.txt:

- بررسی دستی صفحات: ابتدا تمام صفحاتی که در گزارش «مسدود شده توسط robots.txt» قرار دارند را بررسی کنید.

- حذف دستورات اشتباهی: اگر دستور «Disallow» به اشتباه برای یک URL وارد شده، آن را از فایل robots.txt حذف کنید.

- درخواست ایندکس دوباره: پس از اصلاحات، درخواست ایندکس دوباره از گوگل کنید.

- درخواست خزیدن مجدد: از گوگل درخواست کنید تا فایل robots.txt شما را دوباره خزیده و تغییرات را اعمال کند.

با انجام این مراحل، می توانید مشکلات مربوط به «Blocked by robots.txt» و « «indexed though Blocked by robots.txt »» را رفع کنید و سایت خود را برای موتورهای جستجو به طور بهینه تری قابل دسترس کنید.

1. بررسی دستی تمام صفحاتی که در گزارش «Blocked by robots.txt» قرار دارند

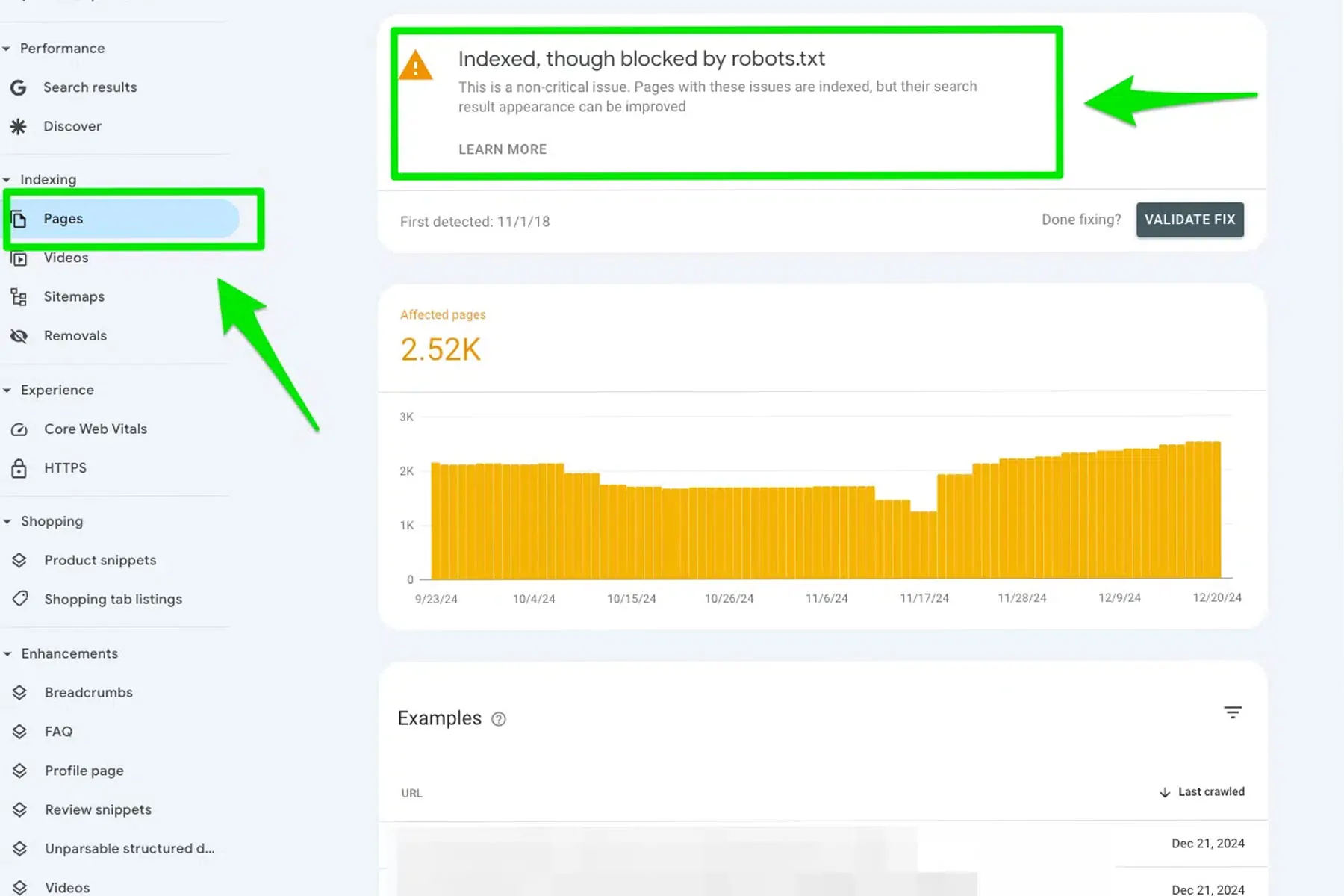

اولین گام برای رفع این ارور این است که به طور دستی تمام صفحاتی که در این گزارش قرار دارند را بررسی کنید. برای دسترسی به گزارش، به مسیر Google Search Console > Pages بروید و در بخش Indexed, though blocked by robots.txt این ارور را پیدا کنید.

پس از یافتن صفحات مسدود شده، داده ها را به Google Sheets، Excel یا CSV صادر کنید و آن ها را فیلتر کنید.

2. تعیین اینکه آیا واقعاً باید این URL ایندکس شود یا خیر

سپس از خود بپرسید که آیا این URL واقعاً باید ایندکس شود؟

- آیا محتوای مفیدی برای کاربران دارد؟

- آیا این URL ارزش ایندکس شدن در موتورهای جستجو را دارد؟

اگر پاسخ به این سوالات منفی است و شما عمداً می خواستید این صفحه مسدود شود، نیازی به انجام هیچ اقدامی ندارید. در این صورت گزارش شما درست است و هیچ نیازی به تغییرات نخواهید داشت.

اما اگر تصمیم دارید که این URL ایندکس شود، باید تغییرات لازم را انجام دهید.

3. حذف دستور «Disallow» از فایل robots.txt و درخواست برای کرال مجدد

اگر به اشتباه دستور Disallow را برای یک URL وارد کرده اید، باید آن را از فایل robots.txt حذف کنید. پس از انجام این تغییرات، URL مورد نظر را در قسمت Inspect URL در Google Search Console وارد کنید و سپس روی گزینه Request Indexing کلیک کنید.

سپس درگوگل سرچ کنسول به مسیر Settings > robots.txt بروید و درخواست کنید تا فایل robots.txt شما دوباره خزیده شود. با این کار گوگل صفحات شما را مجدداً خزیده و ایندکس می کند.

4. اضافه کردن تگ «noindex» برای حذف کامل صفحه از ایندکس

اگر شما نمی خواهید صفحه ای ایندکس شود، بهتر است از تگ noindex استفاده کنید. به طور کلی، بهتر است که به جای استفاده از دستور Disallow در فایل robots.txt، از تگ noindex استفاده کنید تا صفحه کاملاً از ایندکس شدن جلوگیری شود.

با این حال، فراموش نکنید که باید دستور Disallow را از فایل robots.txt حذف کنید تا گوگل بتواند تگ noindex را شناسایی کند. اگر هر دو را همزمان نگه دارید، این ارور در Google Search Console همچنان ادامه خواهد داشت.

چرا باید از تگ «noindex» به جای دستور «Disallow» در robots.txt استفاده کنیم؟

اگر هدف شما این است که صفحه ای کاملاً از موتورهای جستجو حذف شود، باید از تگ noindex استفاده کنید. دلیل این امر این است که دستور Disallow در robots.txt نمی تواند جلوی ایندکس شدن صفحه را بگیرد؛ چرا که این فایل فقط برای کنترل خزیدن استفاده می شود و نه ایندکس شدن.

اگر می خواهید صفحه شما کاملاً از ایندکس شدن جلوگیری شود، باید از تگ noindex استفاده کنید و در عین حال، از اضافه کردن دستور Disallow در robots.txt خودداری کنید.

آیا باید هر دو تگ «noindex» و دستور «Disallow» را برای یک URL قرار دهم؟

پاسخ این سوال منفی است. اگر از تگ noindex برای یک URL استفاده می کنید، نباید همان URL را در فایل robots.txt با دستور Disallow مسدود کنید.

چرا؟ چون موتورهای جستجو نیاز دارند که بتوانند URL شما را خزیده و تگ noindex را شناسایی کنند. اگر شما آن URL را در robots.txt مسدود کنید، گوگل قادر به خزیدن صفحه نخواهد بود و نمی تواند تگ noindex را شناسایی کند.

ایجاد یک استراتژی واضح برای خزیدن سایت

برای جلوگیری از خطای blocked by robot.txt در Google Search Console، باید یک استراتژی خزیدن واضح برای سایت خود ایجاد کنید. این استراتژی باید شامل تصمیم گیری دقیق در مورد صفحاتی باشد که می خواهید از ایندکس شدن جلوگیری کنید.

اگر صفحه ای قصد دارد محتوای ارزشمندی برای کاربران جستجوگر فراهم کند، آن را ایندکس کنید. اما اگر صفحه ای محتوای ارزشمند ندارد و نباید در نتایج جستجو ظاهر شود، مسدود کردن آن از ایندکس شدن منطقی است.

در نتیجه، همیشه قبل از مسدود کردن صفحات از ایندکس شدن، محتوای آن ها را بررسی کنید و تصمیم بگیرید که آیا به طور واقعی ارزش ایندکس شدن دارند یا خیر.

نکات کلیدی برای رفع ارور «ایندکس شده، اما مسدود شده توسط robots.txt»:

- بررسی دقیق صفحات: صفحات مسدود شده را بررسی کرده و تعیین کنید که آیا باید ایندکس شوند یا خیر.

- حذف دستور Disallow: اگر دستور Disallow به اشتباه اضافه شده، آن را از فایل robots.txt حذف کنید.

- درخواست ایندکس دوباره: پس از حذف دستور Disallow، درخواست ایندکس دوباره از گوگل کنید.

- استفاده از تگ noindex: اگر نمی خواهید صفحه ای ایندکس شود، از تگ noindex به جای دستور Disallow استفاده کنید.

- استراتژی خزیدن مشخص: برای جلوگیری از ارورهای مشابه، استراتژی خزیدن دقیقی برای سایت خود تنظیم کنید.

با این اقدامات، می توانید خطای Indexed, though blocked by robot.txtرا رفع کنید و سایت خود را برای گوگل به طور بهینه تری در دسترس قرار دهید.

بیشتر بخوانید:

چرا صفحات وبسایت شما در گوگل کرال میشوند اما ایندکس نمیشوند؟ دلایل و راهکارها

آنالیز سئو سایت با سرچ کنسول، گوگل شیت و ChatGPT به صورت خودکار!